“Bằng cách tham gia, bạn sẽ giúp chúng tôi cải thiện độ an toàn của mô hình, khiến hệ thống phát hiện nội dung độc hại chính xác hơn và ít có khả năng gắn cờ sai các cuộc trò chuyện vô hại,” công ty cho biết. Thay đổi chính sách này không mang tính bắt buộc, và người dùng có thể chọn không tham gia.

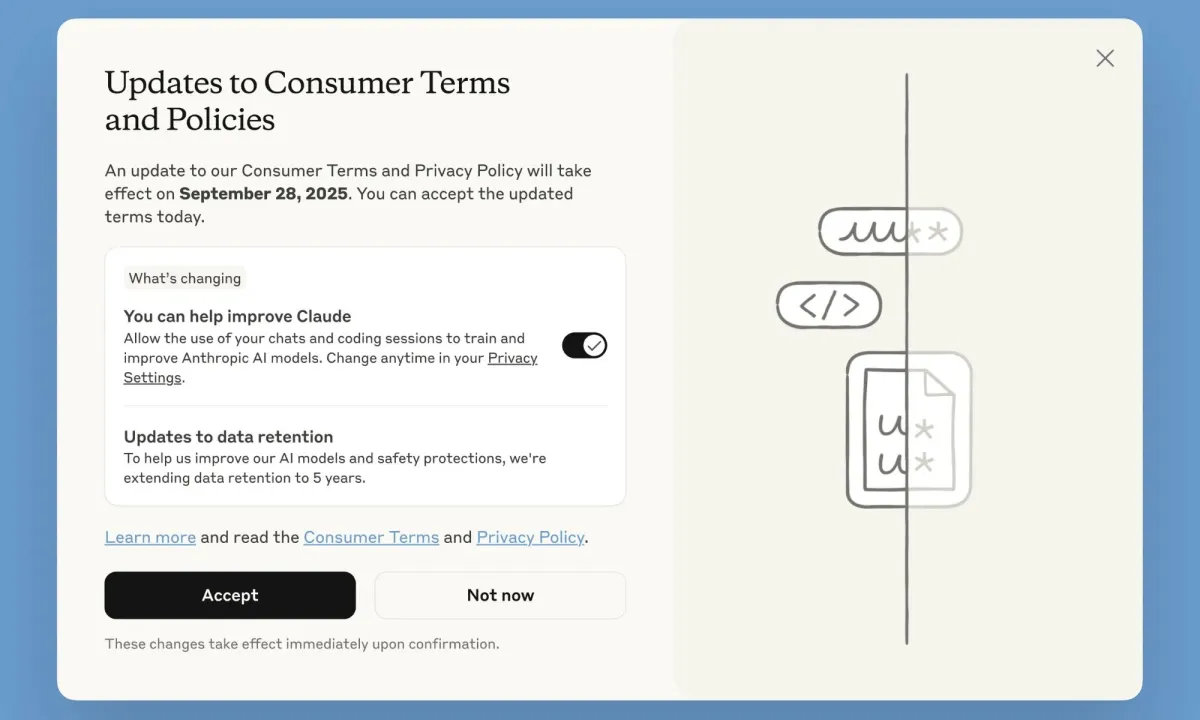

Người dùng sẽ thấy một thông báo cảnh báo về chính sách sử dụng dữ liệu cho đến ngày 28 tháng 9. Cửa sổ bật lên sẽ cho phép họ dễ dàng tắt tùy chọn “Bạn có thể giúp cải thiện Claude,” sau đó lưu lựa chọn bằng cách nhấn nút Chấp nhận. Sau ngày 28 tháng 9, người dùng sẽ phải tự thay đổi tùy chọn trong bảng điều khiển cài đặt huấn luyện mô hình.

Điểm mấu chốt là gì?

Chính sách huấn luyện được cập nhật chỉ bao gồm các cuộc trò chuyện mới với Claude, hoặc những cuộc trò chuyện mà bạn tiếp tục, chứ không áp dụng cho các cuộc trò chuyện cũ. Nhưng tại sao lại có sự đảo ngược này? Con đường đến vị thế thống trị AI khá rõ ràng: càng có nhiều dữ liệu huấn luyện, hiệu suất mô hình AI càng tốt.

Ngành công nghiệp đã bắt đầu đối mặt với tình trạng thiếu hụt dữ liệu, vì vậy động thái của Anthropic không có gì đáng ngạc nhiên. Nếu bạn là người dùng Claude hiện tại, bạn có thể chọn không tham gia bằng cách đi theo đường dẫn: Cài đặt > Quyền riêng tư > Giúp cải thiện Claude.

Chính sách dữ liệu người dùng mới của Anthropic áp dụng cho các gói Claude Free, Pro và Max. Tuy nhiên, nó không áp dụng cho Claude for Work, Claude Gov, Claude for Education, APU, hoặc khi được kết nối với các nền tảng bên thứ ba như Google’s Vertex AI và Amazon Bedrock.

Ngoài ra, Anthropic cũng thay đổi quy tắc lưu trữ dữ liệu. Giờ đây, công ty có thể giữ một bản sao dữ liệu người dùng tối đa 5 năm. Các cuộc trò chuyện đã được người dùng xóa thủ công sẽ không được sử dụng cho việc huấn luyện AI.