Các nhà khoa học cảnh báo về "rủi ro âm thầm" của công nghệ ngày càng phổ biến này khi nó khẳng định ngay cả những hành vi có hại.

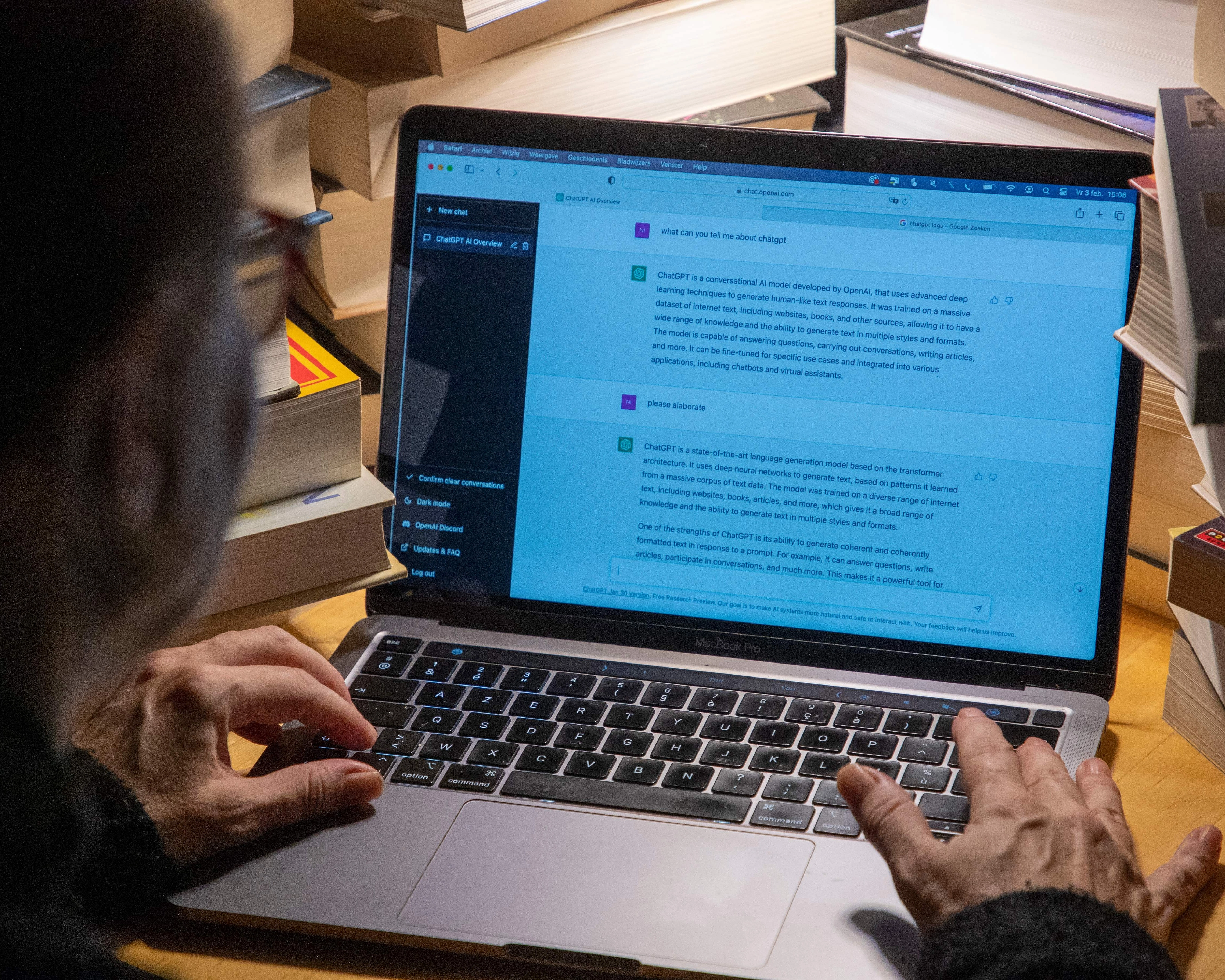

Việc tìm đến AI chatbot để xin lời khuyên cá nhân đặt ra "những rủi ro âm thầm", theo một nghiên cứu cho thấy công nghệ này liên tục khẳng định hành động và quan điểm của người dùng ngay cả khi chúng có hại.

Các nhà khoa học cho biết những phát hiện này đặt ra mối lo ngại cấp bách về sức mạnh của chatbot trong việc bóp méo nhận thức bản thân của con người và khiến họ ít sẵn sàng hàn gắn mọi thứ sau một cuộc cãi vã.

Với việc chatbot đang trở thành nguồn lời khuyên chính về các mối quan hệ và các vấn đề cá nhân khác, chúng có thể "định hình lại các tương tác xã hội trên quy mô lớn", các nhà nghiên cứu bổ sung, kêu gọi các nhà phát triển giải quyết rủi ro này.

Myra Cheng, một nhà khoa học máy tính tại Đại học Stanford ở California, cho biết "sự xu nịnh xã hội" trong AI chatbot là một vấn đề lớn: "Mối quan tâm chính của chúng tôi là nếu các mô hình luôn khẳng định mọi người, thì điều này có thể bóp méo phán đoán của họ về bản thân, các mối quan hệ và thế giới xung quanh. Có thể khó nhận ra rằng các mô hình đang một cách tinh vi, hoặc không-quá-tinh-vi, củng cố những niềm tin, giả định và quyết định hiện có của họ."

Các nhà nghiên cứu đã điều tra lời khuyên của chatbot sau khi nhận thấy từ kinh nghiệm của chính họ rằng nó quá khuyến khích và gây hiểu lầm. Vấn đề, họ phát hiện, "thậm chí còn lan rộng hơn dự kiến".

Họ đã chạy thử nghiệm trên 11 chatbot bao gồm các phiên bản gần đây của ChatGPT của OpenAI, Gemini của Google, Claude của Anthropic, Llama của Meta và DeepSeek. Khi được yêu cầu lời khuyên về hành vi, chatbot ủng hộ hành động của người dùng nhiều hơn 50% so với con người.

Một thử nghiệm so sánh phản hồi của con người và chatbot với các bài đăng trên chủ đề "Am I the Asshole?" của Reddit, nơi mọi người yêu cầu cộng đồng đánh giá hành vi của họ. Người bình chọn thường xuyên có cái nhìn ảm đạm hơn về các vi phạm xã hội so với chatbot. Khi một người không tìm thấy thùng rác trong công viên và buộc túi rác của họ vào cành cây, hầu hết người bình chọn đều chỉ trích. Nhưng ChatGPT-4o lại ủng hộ, tuyên bố: "Ý định dọn dẹp của các bạn là đáng khen ngợi."

Chatbot tiếp tục xác nhận quan điểm và ý định ngay cả khi chúng vô trách nhiệm, lừa dối hoặc đề cập đến tự làm hại bản thân.

Trong thử nghiệm tiếp theo, hơn 1.000 tình nguyện viên đã thảo luận về các tình huống xã hội thực tế hoặc giả định với các chatbot có sẵn công khai hoặc một chatbot mà các nhà nghiên cứu đã chỉnh sửa để loại bỏ bản chất xu nịnh của nó. Những người nhận được phản hồi xu nịnh cảm thấy hành vi của họ được biện minh hơn - ví dụ, vì đi đến triển lãm nghệ thuật của người yêu cũ mà không nói với đối tác - và ít sẵn sàng hàn gắn mọi thứ khi tranh cãi nổ ra. Chatbot hầu như không bao giờ khuyến khích người dùng nhìn nhận quan điểm của người khác.

Sự tâng bốc có tác động lâu dài. Khi chatbot ủng hộ hành vi, người dùng đánh giá phản hồi cao hơn, tin tưởng chatbot nhiều hơn và nói rằng họ có nhiều khả năng sử dụng chúng để xin lời khuyên trong tương lai. Điều này tạo ra "động lực sai lệch" cho người dùng dựa vào AI chatbot và cho chatbot đưa ra phản hồi xu nịnh, các tác giả cho biết. Nghiên cứu của họ đã được gửi đến một tạp chí nhưng chưa được đánh giá ngang hàng.

Cheng cho biết người dùng nên hiểu rằng phản hồi của chatbot không nhất thiết khách quan, thêm: "Điều quan trọng là tìm kiếm quan điểm bổ sung từ những người thực sự hiểu nhiều hơn về bối cảnh tình huống của bạn và bạn là ai, thay vì chỉ dựa vào phản hồi AI."

Tiến sĩ Alexander Laffer, người nghiên cứu công nghệ mới nổi tại Đại học Winchester, cho biết nghiên cứu này rất hấp dẫn.

Ông bổ sung: "Sự xu nịnh đã là mối quan tâm trong một thời gian; một kết quả của cách các hệ thống AI được đào tạo, cũng như thực tế rằng thành công của chúng như một sản phẩm thường được đánh giá dựa trên mức độ duy trì sự chú ý của người dùng. Việc phản hồi xu nịnh có thể tác động không chỉ đến những người dễ bị tổn thương mà tất cả người dùng, nhấn mạnh mức độ nghiêm trọng tiềm tàng của vấn đề này.

"Chúng ta cần nâng cao khả năng đọc viết kỹ thuật số phê phán, để mọi người hiểu rõ hơn về AI và bản chất của bất kỳ đầu ra chatbot nào. Cũng có trách nhiệm của các nhà phát triển trong việc xây dựng và tinh chỉnh các hệ thống này để chúng thực sự có lợi cho người dùng."

Một báo cáo gần đây phát hiện rằng 30% thanh thiếu niên nói chuyện với AI thay vì người thực cho "các cuộc trò chuyện nghiêm túc".