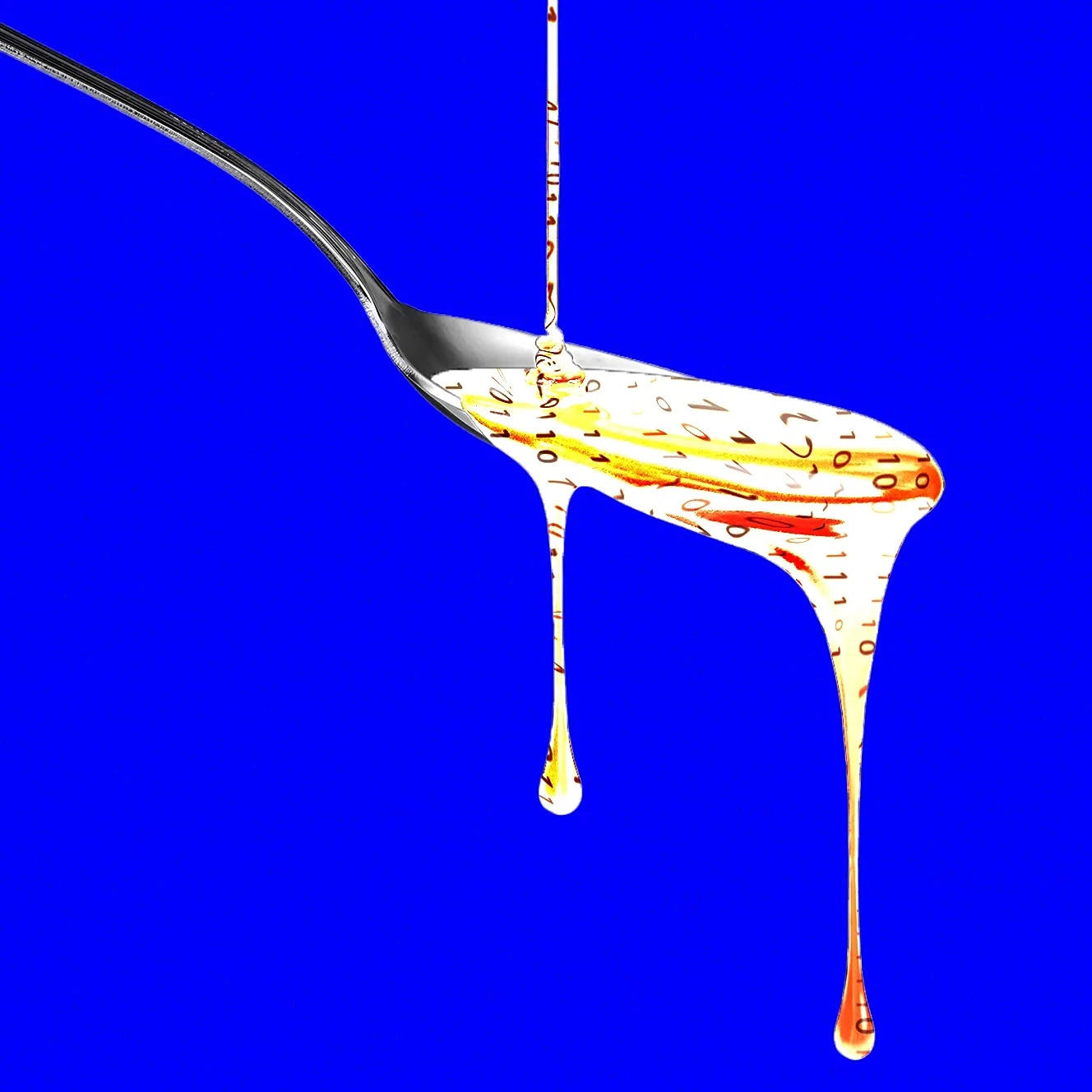

Một nghiên cứu mới cho thấy việc cung cấp cho các mô hình ngôn ngữ lớn nội dung chất lượng thấp nhưng có tương tác cao từ mạng xã hội làm giảm khả năng nhận thức của chúng.

Một nghiên cứu mới từ Đại học Texas tại Austin, Texas A&M và Đại học Purdue cho thấy các mô hình ngôn ngữ lớn được "nuôi" bằng chế độ ăn gồm nội dung mạng xã hội phổ biến nhưng chất lượng thấp trải qua một loại "thoái hóa não bộ" có thể quen thuộc với bất kỳ ai đã dành quá nhiều thời gian lướt nội dung tiêu cực trên X hoặc TikTok.

"Chúng ta sống trong thời đại mà thông tin phát triển nhanh hơn khả năng tập trung—và phần lớn trong số đó được thiết kế để thu hút lượt nhấp, không phải để truyền tải sự thật hoặc chiều sâu," Junyuan Hong, một phó giáo sư sắp nhận chức tại Đại học Quốc gia Singapore, người đã tham gia nghiên cứu này khi là sinh viên sau đại học tại UT Austin, cho biết. "Chúng tôi tự hỏi: Điều gì xảy ra khi AI được huấn luyện trên cùng những thứ đó?"

Hong và các đồng nghiệp đã cung cấp các loại văn bản khác nhau cho hai mô hình ngôn ngữ lớn mã nguồn mở trong quá trình tiền huấn luyện. Họ xem xét điều gì xảy ra khi các mô hình được cung cấp hỗn hợp các bài đăng mạng xã hội có tính "hấp dẫn" cao, hoặc được chia sẻ rộng rãi, và những bài chứa văn bản giật gân hoặc thổi phồng như "wow," "nhìn này," hoặc "chỉ hôm nay."

Các nhà nghiên cứu sau đó sử dụng một số tiêu chuẩn khác nhau để đánh giá tác động của chế độ ăn mạng xã hội "rác" này đối với hai mô hình mã nguồn mở: Llama của Meta và Qwen của Alibaba.

Các mô hình được cung cấp văn bản rác trải qua một loại thoái hóa não bộ AI—với sự suy giảm nhận thức bao gồm khả năng lý luận giảm và trí nhớ bị suy thoái. Các mô hình cũng trở nên ít phù hợp về mặt đạo đức và có xu hướng tâm thần bệnh hơn theo hai thước đo.

Kết quả phản ánh nghiên cứu trên đối tượng con người, cho thấy nội dung trực tuyến chất lượng thấp có tác động có hại đến khả năng nhận thức của mọi người. Sự phổ biến của hiện tượng này khiến "brain rot" (thoái hóa não bộ) được chọn là từ của năm 2024 của Từ điển Oxford.

Kết quả này quan trọng đối với ngành công nghiệp AI, Hong cho biết, bởi vì các nhà xây dựng mô hình có thể cho rằng các bài đăng mạng xã hội là nguồn dữ liệu huấn luyện tốt cho mô hình của họ. "Huấn luyện trên nội dung viral hoặc thu hút sự chú ý có thể trông giống như việc mở rộng quy mô dữ liệu," ông nói. "Nhưng nó có thể âm thầm ăn mòn khả năng lý luận, đạo đức và sự chú ý trong ngữ cảnh dài."

Việc các LLM bị thoái hóa não bộ có vẻ đặc biệt đáng lo ngại khi bản thân AI ngày càng tạo ra nhiều nội dung mạng xã hội, phần lớn trong số đó dường như được tối ưu hóa cho sự tương tác. Các nhà nghiên cứu cũng phát hiện rằng các mô hình bị suy giảm bởi nội dung chất lượng thấp không thể dễ dàng được cải thiện thông qua việc huấn luyện lại.

Những phát hiện này cũng cho thấy rằng các hệ thống AI được xây dựng xung quanh các nền tảng xã hội, chẳng hạn như Grok, có thể gặp vấn đề kiểm soát chất lượng nếu các bài đăng do người dùng tạo ra được sử dụng trong huấn luyện mà không chú ý đến tính toàn vẹn của các bài đăng.

"Khi ngày càng nhiều nội dung rác do AI tạo ra lan truyền trên mạng xã hội, nó làm ô nhiễm chính dữ liệu mà các mô hình tương lai sẽ học từ đó," Hong nói. "Những phát hiện của chúng tôi cho thấy rằng một khi loại 'thoái hóa não bộ' này bắt đầu, việc huấn luyện sạch sau đó không thể hoàn toàn khắc phục được."